Le leak GoogleApi.ContentWarehouse.V1 pour mieux comprendre Google

Un séisme dans le monde du SEO ? La fuite massive de 3 000 documents internes de Google a secoué l’écosystème digital comme jamais auparavant. Un coup d’œil dans les coulisses du plus grand moteur de recherche au monde ? Impossible de passer à côté !

Pourquoi c’est une révolution ? Parce que le SEO est un jeu d’ombres où chaque détail compte. Contenu, maillage interne, signaux utilisateurs… jusqu’ici, on avançait en disséquant des indices. Aujourd’hui, grâce aux documents regroupés sous l’appellation de GoogleApi.ContentWarehouse.V1, on tient entre nos mains des données ultra-précises sur le fonctionnement interne de l’indexation et du classement des pages.

Filtres algorithmiques, scoring des liens, gestion des métadonnées : tout y passe. Dans cet article, on va passer en revue QUELQUES-UNES de ces révélations, les croiser avec nos connaissances en algorithmes et vous montrer comment elles impactent le référencement.

Accrochez-vous, on plonge !

Une plongée dans l’algorithme de Google

L’optimisation pour les moteurs de recherche repose sur un équilibre entre la compréhension des algorithmes de Google et l’adaptation aux attentes des utilisateurs.

Récemment, une fuite de données internes liée à GoogleApi.ContentWarehouse.V1 a révélé des aspects jusqu’alors peu accessibles du fonctionnement de l’indexation et du classement des pages. Cette découverte ouvre la porte à une meilleure compréhension des leviers à actionner pour optimiser un site web de manière plus scientifique et prédictive.

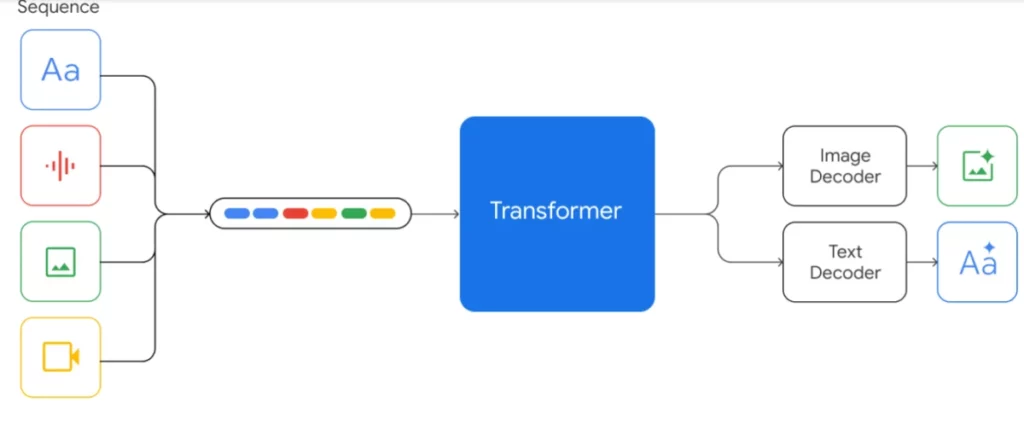

Optimisation des contenus multimédias et SEO vidéo

Google ne se limite plus à analyser du texte, il indexe également des contenus multimédias via une approche multimodale. Les vidéos sont de plus en plus prises en compte dans les résultats de recherche et Google exploite les timestamps pour diriger les utilisateurs vers les passages les plus pertinents. L’analyse de la diversité des miniatures permet aussi d’optimiser le taux de clic (CTR). L’indexation des vidéos repose sur des informations croisées : contenu textuel des sous-titres, éléments visuels et métadonnées associées.

La puissance des métadonnées et l’indexation sémantique

Les documents internes de Google montrent à quel point les métadonnées sont cruciales pour l’indexation efficace des pages. L’algorithme s’appuie sur des champs structurés qui permettent de mieux comprendre les relations entre les entités (personnes, entreprises, produits). Google analyse également les balises meta et alt avec une précision accrue, évaluant la cohérence des descriptions et leur correspondance avec le contenu des pages.

L’automatisation de la modération et son impact sur le SEO

La qualité du contenu est devenue un facteur d’autorité incontournable. Google intègre des systèmes de modération automatisée capables de filtrer le contenu jugé inapproprié. Ces filtres déterminent si une page contient des éléments nuisibles (discours haineux, fake news, contenu sensible) et ajustent son Trust Score, impactant directement son classement dans les résultats de recherche. Il est donc crucial d’adopter une politique éditoriale stricte et de surveiller en permanence les contenus publiés sur un site.

Les interactions utilisateurs comme levier de classement

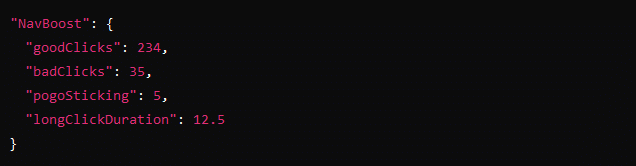

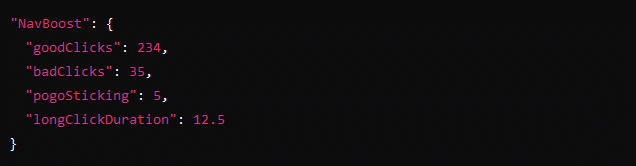

L’analyse du comportement des utilisateurs constitue un axe majeur du classement par Google. L’algorithme NavBoost mesure le temps passé sur une page, le taux de rebond, et les interactions effectuées. Un engagement élevé indique un contenu de qualité. Les pages qui incitent à une navigation prolongée et à des clics pertinents sont valorisées.

Pour réduire le taux de rebond, il est essentiel d’optimiser l’ergonomie du site, d’améliorer la vitesse de chargement et de proposer un contenu engageant qui répond immédiatement aux attentes des visiteurs.

La gestion des contenus géolocalisés et le SEO local

Google applique une analyse précise de la géolocalisation des contenus pour proposer des résultats plus pertinents aux utilisateurs locaux. L’algorithme détecte les informations régionales (adresses, références locales, noms de quartiers) et ajuste la visibilité des pages en fonction de leur pertinence locale. Une stratégie SEO local efficace repose sur la création de pages spécifiques par zone géographique, couplée à des backlinks issus de sites locaux.

Et au niveau des backlinks ?

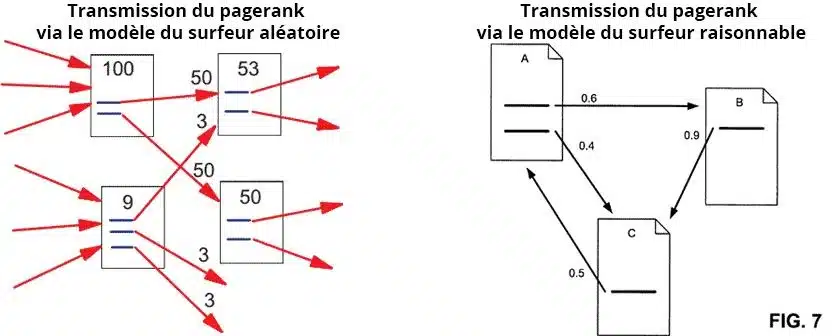

Les backlinks restent l’épine dorsale du SEO offsite. Véritables votes de confiance entre sites web, ils jouent un rôle déterminant dans l’évaluation de la pertinence et de l’autorité d’une page aux yeux de Google. La récente fuite de documents vient confirmer ce que les experts savaient déjà : Google continue d’accorder une importance capitale aux liens entrants, en s’appuyant notamment sur des métriques comme linkInfo et pagerankWeight.

Aucune surprise ici, mais une validation précieuse : les backlinks demeurent indispensables pour toute stratégie SEO offsite efficace. Leur impact ne se limite pas à leur simple présence ; Google les classe selon leur qualité, en analysant leur pagerankWeight et le nombre total de clics générés. Un extrait du document en témoigne :

Google continue d’accorder une importance capitale aux backlinks de qualité. L’algorithme attribue un pagerankWeight en fonction de la pertinence et de l’autorité des sites référents.

La menace du sandboxing et la gestion des Exact Match Domains (EMD)

Les sites dont le nom de domaine est un Exact Match Domain (EMD), c’est-à-dire contenant des mots-clés ultra-optimisés, sont soumis à une période de sandboxing. Google applique une probation allant jusqu’à six mois pour limiter les abus. Pour contourner cette contrainte, il est préférable d’opter pour un nom de domaine de marque et de compenser par une stratégie de contenu et de backlinks solides.

Construire une stratégie SEO durable

Les révélations de GoogleApi.ContentWarehouse.V1 offrent une meilleure compréhension des mécanismes d’indexation et permettent d’affiner les stratégies SEO. L’enjeu n’est plus seulement d’optimiser des mots-clés, mais de structurer un site en tenant compte de l’analyse algorithmique de Google, ce qui inclue des concepts poussés comme l’engagement ou le comportement à partir de certaines sources référentes.

Mais outre ces considérations de surfeurs aléatoires et raisonnables, une stratégie SEO performante repose sur :

- Une expérience utilisateur optimisée pour minimiser le taux de rebond

- Un contenu structuré et enrichi en métadonnées pour améliorer l’indexation

- Une gestion proactive des backlinks et des signaux d’autorité

- Un SEO local pertinent pour capter le trafic régional

En exploitant un peu cette source d’informations incroyables, il est possible de se positionner mieux et de manière durable dans les premiers résultats de recherche, tout en respectant les exigences toujours plus complexes des algorithmes de Google…

L’impact des Core Updates de Google et les critères de qualité…

Chaque nouvelle Core Update de Google provoque son lot d’émoi au sein des experts en SEO. Ces mises à jour majeures peuvent faire dégringoler certaines pages, tandis que d’autres s’envolent, souvent sans raison évidente… En scrutant les documents récemment divulgués, on commence toutefois à discerner la logique qui se cache derrière ces changements.

Il apparaît que Google n’a pas pour objectif de pénaliser arbitrairement certains sites; son but est plutôt de réajuster son index pour mettre en avant ceux qui répondent efficacement à ses critères d’excellence et d’expertise. On constate donc que l’algorithme ne s’appuie pas exclusivement sur les backlinks ou les mots-clés: il prend également en compte des aspects plus nuancés tels que la cohérence sémantique, la crédibilité des sources citées et l’intérêt manifesté par les utilisateurs. En somme, le défi ne se situe plus uniquement dans l’optimisation technique… mais dans une stratégie holistique où le contenu doit être authentiquement précieux.

Et il faut bien que nous considérions cette évolution comme nécessaire – bien qu’exigeante! Certains sites ont exploité pendant trop longtemps des astuces pour tromper le référencement. Aujourd’hui, Google semble privilégier davantage la pertinence et une expérience utilisateur enrichissante. Prenez par exemple le « Quality Score » et l'emphase sur les principes E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) : cela témoigne d’une volonté claire de distinguer un contenu rigoureux et informé du flot incessant de productions sans expertise véritable.

Néanmoins… ces updates ne sont pas exemptes de problèmes : leur opacité demeure un frein majeur. Malgré certaines informations qui ont fuité ici ou là (parenthèses inattendues dans notre monde si hermétique), bien des zones restent obscures; on peine à anticiper avec certitude quel sera l’effet concret d’une update sur nos pages web (« quand vient la tempête… » pourrait-on dire).

D’où cette conclusion: adopter une stratégie SEO pérenne est fondamental – basée sur un contenu solide, référencé auprès de sources dignes de confiance et en ajustement permanent avec les attentes évolutives du géant du web – plutôt que céder aux sirènes des raccourcis séduisants mais précaires… car tôt ou tard, ils attirent les foudres algorithmiques.

Nos certifications

Nos certifications